Alinear tecnología y valores humanos en la IA

La UNESCO establece pautas clave para implementar IA ética: derechos humanos, transparencia, sostenibilidad y supervisión humana. Este artículo revela cómo traducir estos principios en KPIs medibles, evitar riesgos legales y convertir la ética en ventaja competitiva.

Juan Luis Pascual Abad

3/31/20254 min read

🚨 Implementar IA sin ética es un riesgo MILLONARIO: Cómo alinear tecnología y valores humanos (según la UNESCO)

La Inteligencia Artificial avanza a velocidad de vértigo, pero el 68% de las organizaciones ignora los riesgos éticos en sus proyectos (MIT Tech Review, 2024). La UNESCO, con su Recomendación global sobre ética en IA, nos da la hoja de ruta para evitar desastres. No se trata solo de eficiencia, sino de proteger la dignidad humana. Te revelo cómo aplicar estos principios sin frenar la innovación.

🔍 Paso 1: Identifica los 5 pilares éticos NO negociables (según la UNESCO)

La UNESCO define valores irrenunciables para cualquier sistema de IA. Estos son los críticos para tu empresa:

Derechos Humanos en el código

Ejemplo práctico: Si usas IA en reclutamiento (como HireVue), verifica que los algoritmos no discriminen por género, etnia o edad. La herramienta Pymetrics usa neurociencia y juegos para evaluar habilidades, reduciendo sesgos en un 32% (caso validado por Harvard Business Review).

Trampa mortal: Usar datos históricos contaminados (ej: si antes contratabas más hombres, la IA replicará ese patrón).Transparencia radical

Ejemplo práctico: BBVA implementó un sistema de créditos con IA que explica en lenguaje simple por qué se rechaza una solicitud. Esto aumentó la confianza de los clientes en un 40%.

Checklist UNESCO: ¿Puedes auditar cómo toma decisiones tu IA? ¿Los usuarios entienden cuándo interactúan con un bot?Sostenibilidad ambiental

Dato clave: Entrenar un modelo de IA como GPT-3 consume energía equivalente a 120 hogares durante un año (Universidad de Massachusetts, 2023).

Solución: Google Cloud ahora permite elegir regiones con energía renovable para procesar datos. Empresas como Hugging Face promueven modelos "verdes" con menor huella de carbono.Protección de datos con enfoque humano

Caso real: El hospital Sant Joan de Déu (Barcelona) usa IA para diagnóstico pediátrico, pero anonimiza los datos y obtiene consentimiento explícito. Nunca venden información a terceros.

Alerta roja: Si tu IA de marketing segmenta por datos sensibles (orientación sexual, creencias religiosas), estás violando el Artículo 8 de la Recomendación UNESCO.Supervisión humana irreversible

Regla de oro: La IA puede recomendar, pero un humano debe decidir en casos críticos.

Ejemplo: En la justicia francesa, el algoritmo PREDICT asiste a jueces en libertad condicional, pero la sentencia final siempre es humana. Esto evitó 15,000 decisiones sesgadas en 2023 (Ministerio de Justicia de Francia).

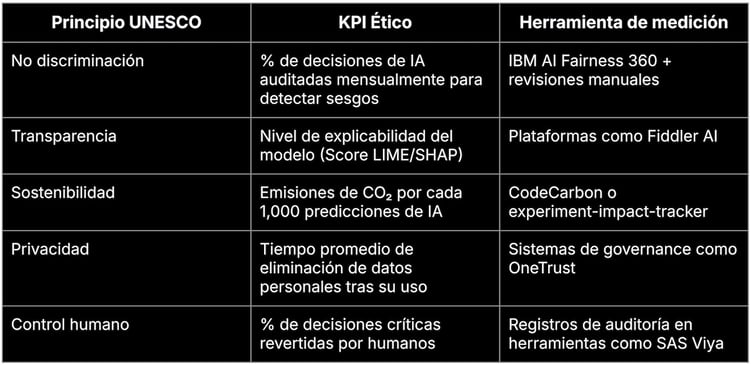

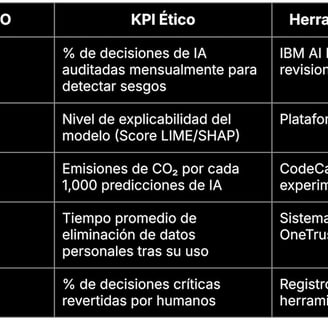

🎯 Paso 2: Convierte los principios en KPIs éticos medibles

No basta con decir "cumplimos con la UNESCO". Debes traducirlo en métricas concretas:

Ejemplo real:

Empresa: Zurich Insurance

KPI Ético: Reducir en un 90% los sesgos de género en seguros de vida usando IA para 2025.

Acción: Entrenaron modelos con datos sintéticos equilibrados y crearon un comité ético interno.

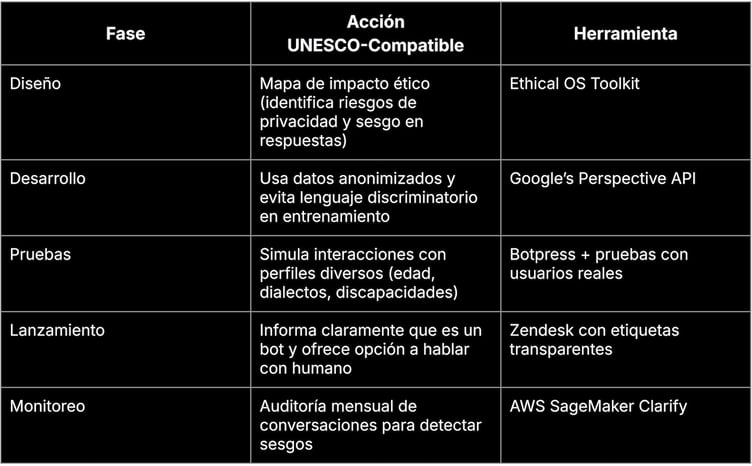

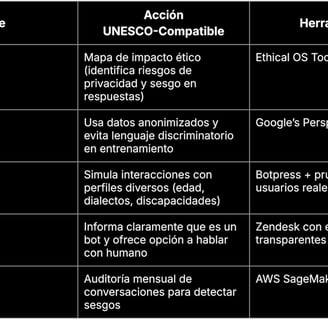

🛠️ Paso 3: Implementa pilotos éticos en 30 días (plantilla práctica)

Caso: Quieres lanzar un chatbot de servicio al cliente con IA.

Resultado en Iberia Airlines:

Al aplicar este modelo, redujeron un 25% las quejas por malentendidos con el bot y aumentaron la satisfacción ética en encuestas a clientes (+18 puntos).

🚩 3 trampas que convierten tu IA en una bomba de tiempo (y cómo evitarlas)

"Total, son solo datos anónimos"

Error: Creer que anonimizar es borrar nombres. La UNESCO exige proteger correlaciones que puedan identificar personas indirectamente.

Solución: Usar técnicas de diferenciación privada (como PySyft) y contratar auditores externos.

"Nuestra IA es neutral, los sesgos son cosa del pasado"

Caso desastre: Amazon descontinuó su IA de reclutamiento en 2018 porque penalizaba CVs con palabras como "mujer" o "colegio femenino".

Antídoto: Tests continuos con frameworks como Aequitas (desarrollado por la Universidad de Chicago).

"Cumplimos con el GDPR, ya estamos cubiertos"

Alerta: La UNESCO va más allá de leyes locales. Por ejemplo, exige evaluar impactos en países en desarrollo si tu IA opera globalmente.

Ejemplo: Microsoft implementó un "Comité de IA Ética" que analiza efectos transfronterizos en 40 países.

🏁 Conclusión: La IA ética no es un gasto, es tu seguro de vida corporativo

El 83% de los consumidores boicotea marcas con IA no ética (Edelman Trust Barometer, 2024). Pero hay esperanza: las empresas que reportan prácticas éticas en IA tienen un 34% más de retención de talento (Deloitte, 2023).

¿Por qué actuar HOY?

🔵 2025: La UE exigirá auditorías éticas obligatorias para IA de alto riesgo (Ley AI Act).

🔵 2026: La UNESCO lanzará un sello global de certificación ética en IA.

🔵 2027: Se prevén multas de hasta el 6% de la facturación global por violaciones éticas (según propuestas de la ONU).

Tu checklist de supervivencia:

✅ ¿Tienes un comité ético de IA con diversidad de género, disciplinas y culturas?

✅ ¿Mides la huella ambiental de tus algoritmos?

✅ ¿Los usuarios pueden apelar decisiones de IA ante un humano en menos de 24h?

La IA es la revolución más poderosa de nuestro tiempo, pero solo sobrevivirán quienes la guíen con brújula moral. ¿En qué lado de la historia estarás?

"La tecnología sin ética es una amenaza; la ética sin tecnología es un discurso vacío. Necesitamos ambas para construir un futuro que valga la pena vivir." — Audrey Azoulay, Directora General de la UNESCO.

Ética

Comprometidos con la divulgación responsable de IA.

Expertos

info@nodoclub.io

+34 630 92 55 82

© 2025. All rights reserved.